[ad#rpsx]Volete fare una copia in locale di alcune pagine o di un intero sito web, completo di scripts, cookies e contenuti in flash (video, audio etc). Comodo per una consultazione offline e per mantenere una copia di backup costantemente aggiornata. Programmi gratuiti per Windows, Linux e Mac OS in grado di svolgere questo compito.

Il Passato

In passato il ricorso a softwares di questo tipo era molto comune, ricordo di aver utilizzato per molto tempo Teleport Pro. In un periodo in cui la connessione si pagava “a tempo” risultava decisamente conveniente scaricare alcune pagine web o un intero sito per poterlo poi consultare a connessione spenta. Daltronde molto del tempo passato online era utilizzato per leggere i contenuti testuali, e ovviamente risultava estremamente utile scaricare in pochi secondi le pagine che ci interessavano per poi leggerle con calma, senza il pensiero del costo della telefonata via modem che incombeva implacabile come una spada di Damocle sulle nostre teste.

Oggi – Vantaggi

Con l’avvento della banda larga, in particolare le linee ADSL ed i conseguenti abbonamenti FLAT, questa esigenza è venuta meno. Ciononostante l’uso di un programma di questo tipo può portare molti vantaggi. Avere un sito in locale, sempre a portata di mano (ehm.. mouse) ci permette di consultarlo anche quando la nostra connessione ad internet non è disponibile.

Poi c’è anche il discorso della velocità, qualunque sia la velocità della nostra linea, l’hard disk risulterà comunque più performante e ci permetterà di caricare pagine web complesse in brevissimo tempo.

Non dimentichiamo poi la possibilità di fare copie di backup dei nostri siti, così da non perdere nulla in caso di crash dei server in cui sono ospitati.

Programmi Gratuiti per salvare interi siti

Bene, esposti i vantaggi e le motivazioni che possono spingerci a salvare interi siti web, andiamo a presentare i softwares adatti a svolgere questo compito.

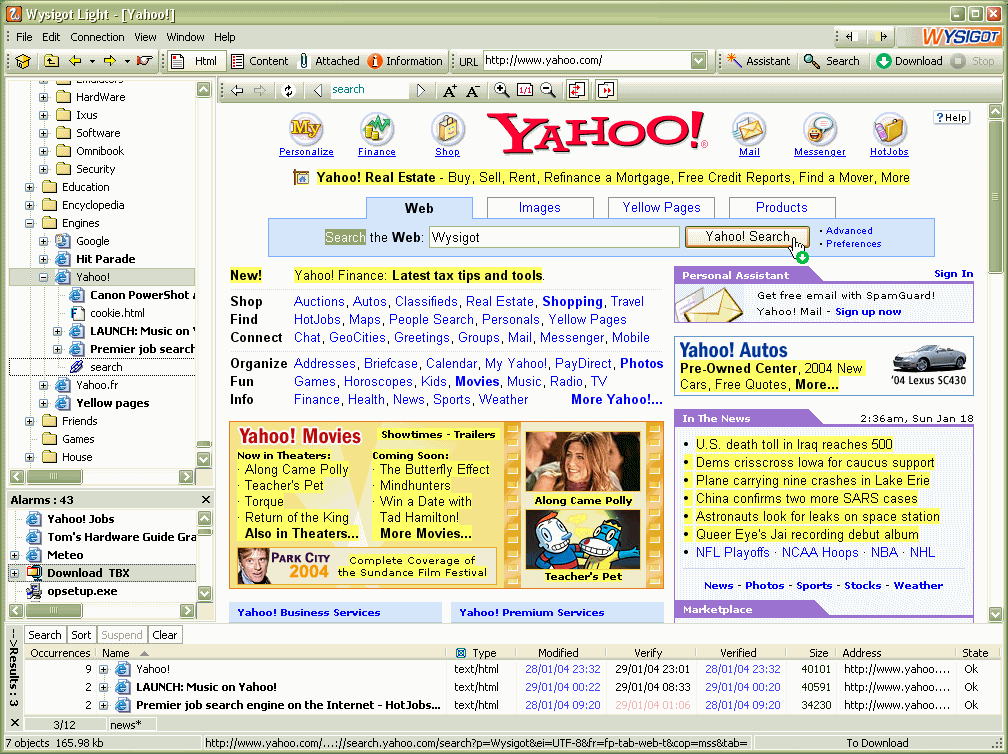

[ad#rpdx]Wisygot – Per Windows. E’ in grado di catturare singole pagine o un intero sito, compresi gli scripts, contenuti in Flash e cookies. Può monitorare costantemente un sito in modo da scaricare eventuali modifiche (nuove pagine etc) non appena verranno rese disponibili (sincronizzazione online->locale). Raffigurazione ad albero del sito. Evidenzia le nuove pagine in giallo, così da permettere di riconoscere “a colpo d’occhio” le novità. Download completamente personalizzabile: livello di profondità dei links, periodo di aggiornamento etc.

Funziona come un browser, permettendo la visione delle pagine direttamente dall’interfaccia del programma. Versione Lite completamente gratuita.

HTTrack Website Copier – Per Windows, Linux e Mac OS X. Gratuito ed Open Source. Può scaricare interi siti WEB creando una copia locale completa di codice HTML, Scripts, Immagini ed altri files. Aggiorna copie locali già esistenti aggiungendo i nuovi contenuti. Potete visualizzare le pagine salvate con il vostro browser preferito. Completamente personalizzabile: livello di profondità, limiti di banda, numero di connessioni contemporanee, filtri per esclusione contenuti e/o links ed altri parametri.[ad#pub]

x Mikele: io ho usato lo storico Teleport Pro che prevede la possibilità di inserire (tra le proprietà del progetto, che viene salvato per futuri utilizzi) una user ed una password. Sto però esplorando altri sw e sono curioso di vedere come funziona httrack in quanto utilizzo pc sia con Win che con Linux e vorrei quindi avere un unico programma da gestire da dove voglio.

PS: un grazie ad AINU per la segnalazione. Farò sapere il mio parere su httrack non appena possibile per condividere esperienze e recensioni.

ciao..conosco il programma ma nel mio caso devo scaicare un sito ke necessita d user e password x poter accedere alle info!

è possibile impostare httrack in modo da entrare nel mio account ed estrarre il sito i maniera corretta o forse dovrei usare qlk altro prog?? HELP!!! xD

Ho solo visto velocemente HTTrack e non ho avuto modo di provarlo a fondo. Per quanto riguarda il tuo quesito, da qualche parte ci deve essere l’indicazione del livello di profondità (depth) desiderato. In pratica, a partire da una certa pagina puoi scaricare ricorsivamente tutte le pagine raggiungibili da questa mediante links, la profondità indica appunto la distanza (in termine di links) dalla pagina iniziale.

Puoi trovare una guida dettagliata qui: http://www.httrack.com/html/step.html

La profondità può essere impostata dal pannello delle opzioni, una guida qui: http://www.httrack.com/html/step9_opt2.html

Ciao!

Interessantissimo articolo. Sono molto incuriosito dalle funzionalità e dai possibili utilizzi di HTTrack e per questo che lo ho installato da poco sul mio PC. Essendo la mia prima esperienza con questo software non sono riuscito bene nel mio intento, ovvero, scaricare in locale un blog che da poco ha chiuso i battenti per collaborare con un portale, nonostante ciò è ancora on-line, anche se dopo pochi istanti rindirizza verso il portale di cui prima dicevo, ho cosi avviato il download ma alla fine controllo i file e scopro che viene scaricato solo l’index, la pagina principale, che comunque conserva la funzione di rindirizzo. Ora sarei felice di poterne capire di più, sia che possa avvenire tramite voi, sia che possa avvenire tramite suggerimento di qualche guida dedicata. Grazie. Ottimo Blog 😉